Werte Besucherin, Werter Besucher, Willkommen!

-

alexander-stannigel.eu —

alexander-stannigel.eu — Autosport-Statistik!

Donnerstag, 4. Dezember 2025

Autosport-Statistik!

Donnerstag, 4. Dezember 2025

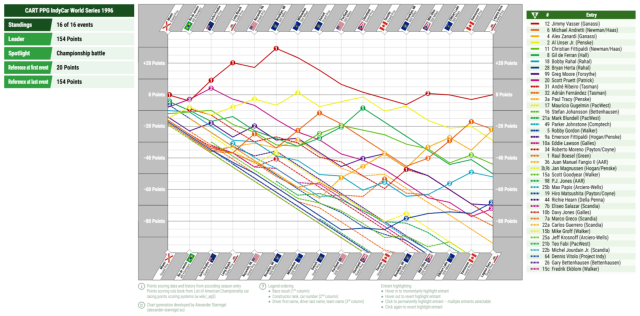

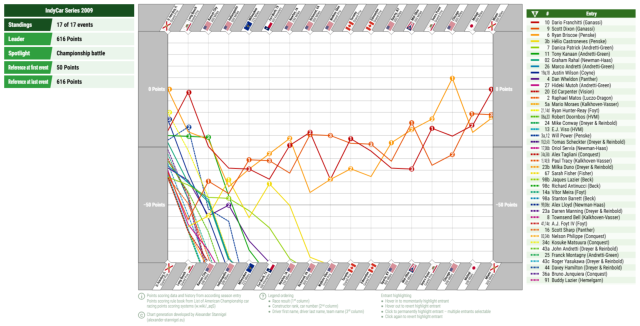

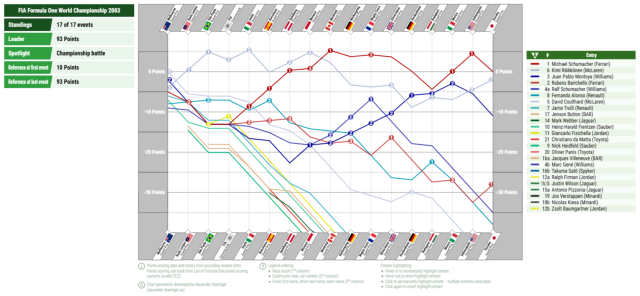

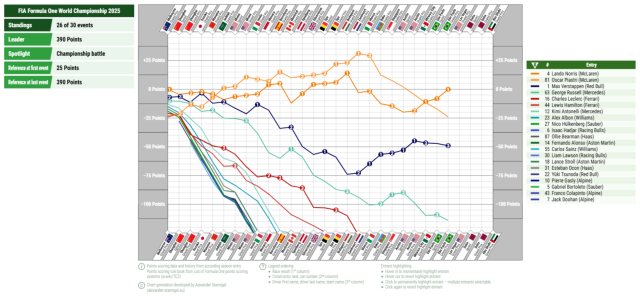

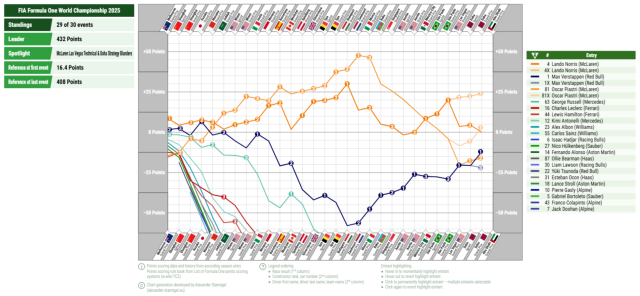

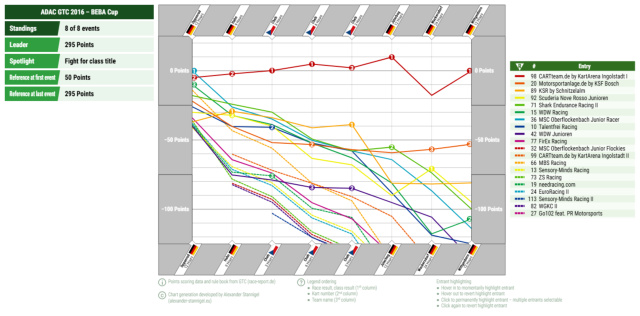

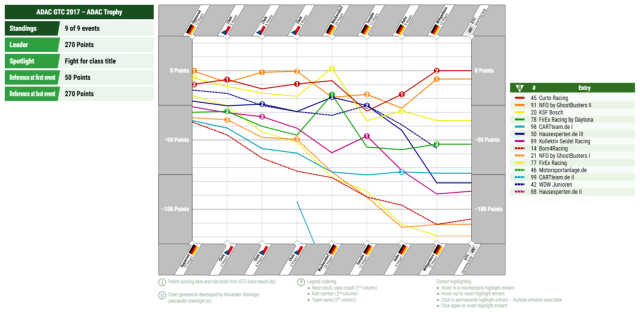

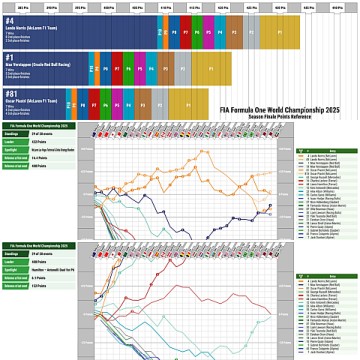

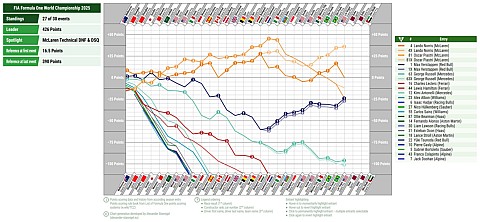

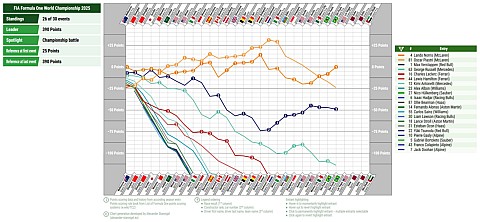

Die Werte werden relativ so dargstellt, dass zum ersten Rennen die dort erreichbare Punktezahl als Startreferenz dient und die nach dem letzten aktuellen Rennen bzw. Punkteereignis führenden Fahrer bzw. Teams die Zielreferenz bilden. Bei den Rennen dazwischen wird anhand der bis dahin erzielbare Punktezahl – jeweils ohne Zusatzpunkte – die jeweilige Referenz im Verhältnis zu Start- und Zielreferenz berechnet. Würde jedes Rennen die volle Punktzahl erzielt, würde dies eine gerade Linie ergeben. Änderungen um die gleiche Punktzahl ergeben so immer den gleichen Anstieg zwischen zwei Rennen. Und falls ich einen manuellen Zielreferenzpunktzahl angebe, wird die Startpunktzahl automatisch entsprechend zum Führenden angepasst.

Für ein paar ausgewählte Champ Car-, IndyCar- und Formel 1- sowie Klassen der ADAC GTC-Saisons

habe ich das probehalber mal durchgeführt. Jetzt müsste ich die Daten nur automatisiert von einer zuverlässigen Quelle erfassen können. Wobei Punktabzüge durch den jeweiligen Verband sowieso immer nochmal eine manuelle Prüfung benötigen… na mal schauen.

habe ich das probehalber mal durchgeführt. Jetzt müsste ich die Daten nur automatisiert von einer zuverlässigen Quelle erfassen können. Wobei Punktabzüge durch den jeweiligen Verband sowieso immer nochmal eine manuelle Prüfung benötigen… na mal schauen.

Champ Car 1996 – 2001

Champ Car-Saison 1996 mit Blick auf den Kampf um die Meisterschaft:Champ Car-Saison 1997 mit Blick auf den Kampf um die Meisterschaft

Champ Car-Saison 1998 mit Überblick über die Meisterschaft

Champ Car-Saison 1998 mit Blick auf den Kampf um Rang 2

Champ Car-Saison 1999 mit Blick auf den Kampf um die Meisterschaft

Champ Car-Saison 2000 mit Blick auf den Kampf um die Meisterschaft

Champ Car-Saison 2001 mit Blick auf den Kampf um die Meisterschaft

IndyCar

IndyCar-Saison 2009 mit Blick auf den Kampf um die Meisterschaft:IndyCar-Saison 2009 mit Überblick über die Meisterschaft

IndyCar-Saison 2009 mit Blick auf den Kampf um Rang 4

IndyCar-Saison 2015 mit Blick auf den Kampf um die Meisterschaft

IndyCar-Saison 2017 mit Blick auf den Kampf um die Meisterschaft

IndyCar-Saison 2019 mit Blick auf den Kampf um die Meisterschaft

Formel 1

Formel 1-Saison 2003 mit Blick auf den Kampf um die Meisterschaft:Formel 1-Saison 2007 mit Blick auf den Kampf um die Meisterschaft

Formel 1-Saison 2010 mit Blick auf den Kampf um die Meisterschaft

Formel 1-Saison 2021 mit Blick auf den Kampf um die Meisterschaft

Formel 1-Saison 2021 mit Überblick über die Meisterschaft

Formel 1-Saison 2021 mit Blick auf den Kampf um Rang 3

Formel 1-Saison 2025

Formel 1-Saison 2025 – Zwischenstand São Paulo mit Blick auf den Kampf um die Meisterschaft:Formel 1-Saison 2025 – Zwischenstand São Paulo mit Überblick über die Meisterschaft

Formel 1-Saison 2025 – Zwischenstand São Paulo mit Blick auf den Kampf um die Rang 9

Formel 1-Saison 2025 – Zwischenstand Las Vegas mit Blick auf die technischen Defekte & Disqualifikationen von McLaren in Zandvoort und Las Vegas und deren Auswirkungen auf die Meisterschaft

Formel 1-Saison 2025 – Zwischenstand Doha mit Blick auf den Kampf um die Meisterschaft

Formel 1-Saison 2025 – Zwischenstand Doha mit Überblick über die Meisterschaft

Formel 1-Saison 2025 – Zwischenstand Doha mit Fokus auf das Duell zwischen Kimi Antonelli und Lewis Hamilton um Rang 6

Formel 1-Saison 2025 – Zwischenstand Doha mit Fokus auf das Williams-interne Duell zwischen Alex Albon und Carlos Sainz Jr. um Rang 8

Formel 1-Saison 2025 – Zwischenstand Doha mit Blick auf den Kampf um Rang 10

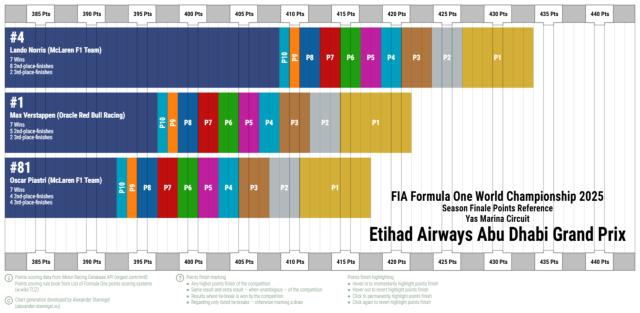

Formel 1-Saison 2025 – Zwischenstand Doha mit Blick auf die technischen und strategischen Aussetzer von McLaren in Las Vegas und Doha und deren Auswirkungen auf die Meisterschaft:Formel 1-Saison 2025 Punktevorschau zum Finale in Abu Dhabi:ADAC GTC – CARTteam.de 2016 & 2017

ADAC GTC 2016 – BEBA Cup-Klasse mit Blick auf den Kampf um die Meisterschaft:ADAC GTC 2017 – ADAC Trophy-Klasse mit Blick auf den Kampf um die Meisterschaft:Permalink: alexander-stannigel.eu -

Alexander Stannigel Dienstag, 2. Dezember 20251

Alexander Stannigel Dienstag, 2. Dezember 20251 Permalinks: facebook.com | alexander-stannigel.eu

Permalinks: facebook.com | alexander-stannigel.eu -

Alexander Stannigel Sonntag, 30. November 20251

Alexander Stannigel Sonntag, 30. November 20251 Permalinks: facebook.com | alexander-stannigel.eu

Permalinks: facebook.com | alexander-stannigel.eu -

Alexander Stannigel Sonntag, 23. November 20251 KommentarPermalinks: facebook.com | alexander-stannigel.eu

Alexander Stannigel Sonntag, 23. November 20251 KommentarPermalinks: facebook.com | alexander-stannigel.eu -

Alexander Stannigel Mittwoch, 19. November 20252

Alexander Stannigel Mittwoch, 19. November 20252 |

5 Kommentare

Permalinks: facebook.com | alexander-stannigel.eu

|

5 Kommentare

Permalinks: facebook.com | alexander-stannigel.eu

– den Verlauf ähnlich der Renndiagramme darstellen zu können und Trends und Trendwenden besser sichtbar zu machen. Und prinzipiell hatte ich die entsprechende Generierung solcher Diagramme ja schonmal programmiert. Also brauchte ich «nur noch» die entsprechenden Datenquellen zu erfassen – wenn auch noch manuell – und die Referenzwerte bestimmmen.

– den Verlauf ähnlich der Renndiagramme darstellen zu können und Trends und Trendwenden besser sichtbar zu machen. Und prinzipiell hatte ich die entsprechende Generierung solcher Diagramme ja schonmal programmiert. Also brauchte ich «nur noch» die entsprechenden Datenquellen zu erfassen – wenn auch noch manuell – und die Referenzwerte bestimmmen.